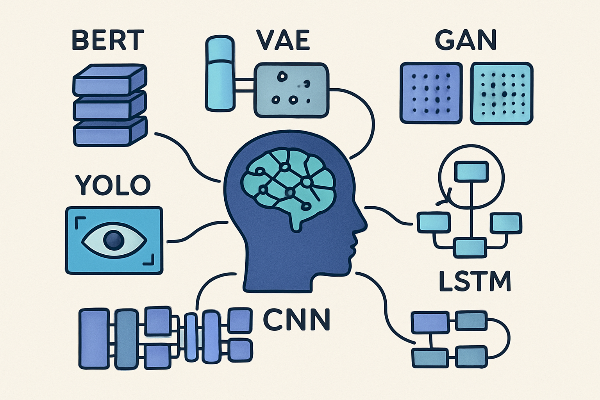

인공지능 분야는 다양한 목적과 응용 분야에 따라 수많은 모델들이 개발되어 왔다. 이러한 모델들은 처리하는 데이터 유형, 학습 방법, 그리고 해결하고자 하는 문제의 특성에 따라 분류할 수 있다. 본 분석에서는 시각적 처리, 생성형 모델, 자연어 처리, 특수 목적 모델 등 다양한 관점에서 AI 모델들을 종합적으로 검토한다.

시계열 및 순차 데이터 처리 모델

RNN (Recurrent Neural Network)

순환 신경망은 시퀀스 데이터를 처리하기 위해 고안된 신경망으로, 히든 노드가 방향성 있는 엣지로 연결되어 순환 구조를 형성한다. 현재 상태의 히든 state는 직전 시점의 히든 state를 받아 갱신되는 구조를 가지며, 음성 인식, 기계번역, 감성 분석 등 다양한 분야에 활용된다.

주요 특징으로는 시간 순서를 고려한 데이터 처리가 가능하며, 입력과 출력을 시퀀스 단위로 처리한다. 그러나 장기 의존성 문제와 그래디언트 소실/폭발 문제를 겪는다는 한계가 있다.

LSTM (Long Short-Term Memory)

LSTM은 RNN의 장기 의존성 문제를 해결하기 위해 개발된 모델이다. RNN의 히든 state에 cell-state를 추가한 구조로, 이 cell state는 컨베이어 벨트 역할을 하여 그래디언트가 오래 경과하더라도 비교적 잘 전파되도록 한다.

핵심 구조는 세 가지 게이트로 구성된다. Forget gate는 과거 정보를 선택적으로 잊기 위한 게이트이며, Input gate는 현재 정보를 기억하기 위한 게이트, Output gate는 최종 출력을 결정하는 게이트다. 이러한 게이트 메커니즘을 통해 LSTM은 장기 의존성을 효과적으로 학습하고 그래디언트 문제를 해결한다.

활용 분야로는 음성 인식, 기계번역, 주식 가격 예측, 시계열 데이터 분석, 동작 인식 등이 있다. 특히 시퀀스의 시간적 특성을 고려해야 하는 모든 작업에서 강력한 성능을 발휘한다.

이미지 처리 모델

CNN (Convolutional Neural Network)

합성곱 신경망은 이미지 및 시각적 데이터 처리를 위해 개발된 신경망이다. 이미지의 패턴을 인식하고 이미지 분류, 물체 인식, 얼굴 인식 등 다양한 과제에서 뛰어난 성능을 발휘한다.

핵심 원리는 이미지의 공간 정보를 유지한 상태로 학습이 가능하다는 점이다. 각 레이어의 입출력 데이터 형상을 유지하며, 복수의 필터로 이미지 특징을 추출한다. 필터를 공유 파라미터로 사용하기 때문에 일반 인공 신경망과 비교하여 학습 파라미터가 적다.

주요 구성 요소는 Convolution Layer(특징 추출), Pooling Layer(특징 압축), Fully Connected Layer(분류)로 구성된다. Convolution Layer는 필터를 활용하여 이미지의 특징 지도를 만들며, Pooling Layer는 특징 지도를 일정 크기의 영역으로 구분하여 대표값을 결정한다.

VGGNet

VGGNet은 2014년 ILSVRC 대회에서 2위를 차지한 모델로, 네트워크 깊이가 성능에 미치는 영향을 확인하기 위해 개발되었다. 구조가 간단하여 오늘날까지도 백본 모델로 많이 사용된다.

핵심 특징으로는 3×3 크기의 작은 필터만 사용하여 깊은 네트워크를 구축한다. 작은 필터를 중첩해서 사용하면 큰 필터를 사용하는 것보다 파라미터 개수가 적으며, 레이어가 많아질수록 활성화 함수를 더 많이 사용하여 비선형성이 높아진다.

ResNet

ResNet은 스킵 커넥션을 이용해 기울기 소실 문제를 해소한 모델이다. VGG가 19층 이상 쌓을 수 없었던 것과 달리, ResNet은 합성곱층을 100층까지 쌓을 수 있다.

핵심 개념은 Residual Learning으로, 입력값을 출력값에 더해주는 Skip Connection을 통해 그래디언트가 깊은 네트워크를 통과하면서도 소실되지 않도록 한다. 이를 통해 매우 깊은 네트워크에서도 효과적인 학습이 가능하다.

ImageNet 대회에서 Top-5 에러율 3.57%를 기록했는데, 이는 사람의 이미지 분류 오차율 5%보다 더 좋은 결과다.

YOLO (You Only Look Once)

YOLO는 실시간 객체 탐지를 위한 알고리즘으로, 이미지를 한 번만 보고 바로 물체를 검출하는 특징을 가진다. CNN 기반으로 특징을 추출한 뒤 물체의 종류와 위치를 예측한다.

작동 원리는 입력 이미지를 격자 무늬의 그리드 셀로 나눈 뒤 각 그리드 셀별로 Bounding Box를 예측한다. NMS(Non-Maximum Suppression) 과정을 통해 최종적으로 확률값이 높은 예측 결과만 남긴다.

주요 장점은 이전 모델들과 달리 이미지를 한 번만 확인하여 처리 속도가 매우 빠르다는 점이다. 실시간 물체 검출이 필요한 경우에 매우 유용하며, 자율주행, 보안 시스템, 로봇 공학 등에 활용된다.

생성형 모델

GAN (Generative Adversarial Network)

생성적 적대 신경망은 두 개의 경쟁적인 신경망을 사용하여 새로운 데이터를 생성하는 딥러닝 아키텍처다. 생성자(Generator)와 판별자(Discriminator)가 서로 대립하며 학습하여 더 정확한 출력을 생성한다.

작동 방식은 위조자(생성자)와 미술 비평가(판별자) 간의 경쟁에 비유할 수 있다. 생성자는 실제와 유사한 가짜 데이터를 만들고, 판별자는 실제 데이터와 가짜 데이터를 구별한다. 이 과정이 반복되면서 생성자는 점점 더 정교한 데이터를 생성하게 된다.

활용 분야로는 이미지 생성, 스타일 전이, 초해상도 이미지 생성, 합성 데이터 생성, 이상 탐지 등이 있다. 특히 의료 분야에서는 환자 개인정보를 침해하지 않으면서 학습용 의료 스캔 데이터를 생성하는 데 활용된다.

VAE (Variational Autoencoder)

변분 오토인코더는 확률 모델을 기반으로 데이터를 학습하는 딥러닝 모델이다. 기본 오토인코더와 달리 데이터의 잠재 공간을 확률적 분포로 학습하여 다양한 데이터를 생성할 수 있다.

핵심 개념은 인코더가 잠재 변수를 직접 출력하는 대신, 잠재 변수가 따르는 확률 분포의 평균과 분산을 학습한다는 점이다. 이를 통해 잠재 공간에서 임의의 벡터를 샘플링해도 의미 있는 결과를 생성할 수 있다.

활용 분야는 이미지 생성, 데이터 증강, 차원 축소, 이상 징후 탐지, 스타일 변환 등이 있다. GAN과 비교하면 VAE는 학습이 더 안정적이며, 잠재 공간이 연속적이라는 장점이 있다.

Diffusion Model

디퓨전 모델은 이미지를 무작위 상태(노이즈)에서 시작해 여러 차례에 걸쳐 조금씩 원래 형태를 복원해가는 과정을 통해 최종 이미지를 만든다.

작동 원리는 두 가지 과정으로 나뉜다. Forward Process에서는 원본 이미지에 점차적으로 노이즈를 추가하여 순수한 노이즈 상태로 만든다. Reverse Process에서는 노이즈 상태에서 시작하여 원본 이미지로 복원하는 과정을 학습한다.

노이즈 추가 및 제거의 이유는 데이터 분포 학습, 안정적 학습, 점진적 개선 등이 있다. AI가 이미지가 어떻게 구성되는지를 역방향으로 추적하는 방법을 배우며, 각 단계마다 노이즈 제거량을 명확하게 측정할 수 있어 학습이 안정적이다.

자연어 처리 모델

Transformer

트랜스포머는 2017년 Google Brain이 발표한 "Attention is All You Need" 논문을 통해 소개된 모델로, 기존 RNN 구조를 대체하는 새로운 접근 방식을 제시했다.

핵심 요소는 입력 임베딩, 포지셔널 인코딩, 어텐션 메커니즘, 피드포워드 신경망, 정규화와 잔차 연결이다. 특히 어텐션 메커니즘은 입력 시퀀스 내에서 어떤 단어에 얼마나 집중할지를 결정하는 핵심 기술이다.

셀프 어텐션은 Query, Key, Value 행렬을 사용하여 계산된다. 입력 벡터들 간 유사도를 계산하고, 이를 가중치로 변환하여 최종 출력값을 만든다. 멀티 헤드 어텐션을 통해 다양한 시각에서 문맥을 파악할 수 있다.

BERT (Bidirectional Encoder Representations from Transformers)

BERT는 양방향으로 문맥을 이해할 수 있는 모델로, 트랜스포머의 인코더만을 사용한다. 마스크 언어 모델링을 통해 문장 중간의 빈칸을 맞추는 과정에서 학습한다.

주요 특징은 양방향 학습으로 문장의 모든 문맥을 고려할 수 있으며, MLM(Masked Language Modeling)을 통해 단어들 간의 관계를 학습한다. 사전 학습 후 특정 작업에 맞게 미세 조정이 가능하다.

활용 사례로는 질문 답변 시스템, 텍스트 분류, 문장 유사도 계산, 개체명 인식 등이 있다. 문장의 의미를 추출하는 작업에 강점을 가진다.

GPT (Generative Pre-trained Transformer)

GPT는 언어 모델로서 이전 단어들이 주어졌을 때 다음 단어를 예측하는 과정에서 학습한다. 트랜스포머의 디코더만을 사용하며, 단방향으로 문장을 생성한다.

핵심 차이는 BERT가 양방향으로 문맥을 이해하는 반면, GPT는 왼쪽에서 오른쪽으로 순차적으로 단어를 생성한다. 이러한 특성 때문에 GPT는 텍스트 생성에, BERT는 문장 이해에 강점을 보인다.

적용 분야는 텍스트 생성, 대화형 AI 시스템, 글 작성 보조, 콘텐츠 생성 등이다. ChatGPT는 GPT 모델을 활용한 대표적인 사례다.

BART와 T5

BART와 T5는 인코더-디코더 구조를 모두 사용하는 시퀀스-투-시퀀스 모델이다.

BART는 문서를 손상시킨 후 원본을 재구성하는 방식으로 학습하며, 다양한 노이즈 기법을 적용한다. 텍스트 요약, 번역, 질의응답 등에서 우수한 성능을 보인다.

T5는 모든 NLP 작업을 텍스트-투-텍스트 형식으로 통일하여 처리한다. 입력 시퀀스의 일부 토큰을 삭제하고 특수 토큰으로 대체하는 방식으로 학습한다. 다양한 작업에 동일한 모델 아키텍처를 사용할 수 있다는 장점이 있다.

LLM (Large Language Model)

대규모 언어 모델은 무수히 많은 파라미터로 구성된 언어 모델로, 상당한 양의 텍스트 데이터를 학습하여 자연어의 복잡성을 이해한다.

대표 모델로는 GPT 시리즈, Google의 PaLM과 BERT, Meta의 LLaMA 등이 있다. 이들 모델은 수십억에서 수천억 개의 파라미터를 가지며, 인간 수준의 언어 이해와 생성 능력을 보인다.

특수 목적 모델

U-Net

U-Net은 의료 영상 분석을 위해 개발된 세그멘테이션 모델이다. 모델 구조가 'U'자 형태를 가지고 있어 이러한 이름이 붙었다.

핵심 구조는 Contracting Path(수축 경로), Bottleneck(병목), Expansive Path(확장 경로)로 구성된다. Skip Connection을 통해 인코더의 고해상도 정보를 디코더에 직접 전달하여 정밀한 경계 복원이 가능하다.

주요 장점은 소규모 데이터셋으로도 효과적이며, 고해상도 이미지의 정확한 경계 분할 성능이 뛰어나다는 점이다. 의료 이미지 분석, 세포 분할, 조직 분할 등에 활용된다.

GNN (Graph Neural Network)

그래프 신경망은 그래프로 구조화된 데이터에 대한 추론을 수행하도록 설계된 신경망이다. 노드와 간선으로 표현된 관계형 데이터를 효과적으로 처리한다.

작동 원리는 메시지 전달 또는 이웃 집계를 통해 각 노드가 인접 노드로부터 정보를 수집하고 자신의 특징을 업데이트한다. 이 과정을 여러 레이어에 걸쳐 반복하여 그래프 전체의 구조 정보를 반영한다.

활용 분야는 신약 개발, 소셜 네트워크 분석, 추천 시스템, 교통 예측, 분자 구조 분석 등이다. 관계형 데이터를 다루는 모든 분야에서 활용 가능성이 높다.

DQN (Deep Q-Network)

DQN은 딥러닝과 강화학습을 결합한 대표적인 가치 기반 강화학습 알고리즘이다. Q-learning에 CNN을 결합하여 복잡한 상태 공간에서도 학습이 가능하도록 했다.

핵심 기법은 Experience Replay와 Target Network다. Experience Replay는 경험 데이터를 메모리에 저장하고 랜덤 샘플링하여 학습함으로써 데이터 간 상관관계 문제를 해결한다. Target Network는 학습의 안정성을 위해 별도의 네트워크를 사용하여 타겟값을 계산한다.

활용 분야는 게임 AI, 로봇 제어, 자율주행, 자원 관리 등이다. DeepMind의 Atari 게임 플레이는 DQN의 대표적인 성공 사례다.

모델 선택 시 고려사항

AI 모델을 선택할 때는 여러 요소를 종합적으로 고려해야 한다.

데이터 유형에 따라 이미지 데이터는 CNN 계열, 시계열 데이터는 LSTM/Transformer, 텍스트는 Transformer 계열, 그래프 데이터는 GNN을 선택한다.

작업 목적에 따라 분류는 CNN/ResNet, 생성은 GAN/VAE/Diffusion, 세그멘테이션은 U-Net, 객체 탐지는 YOLO, 번역/요약은 BART/T5를 고려한다.

데이터 규모와 계산 자원, 실시간 처리 요구사항, 정확도 요구수준 등도 중요한 고려사항이다.

향후 전망

AI 모델 개발은 계속해서 진화하고 있다. 멀티모달 모델이 등장하여 텍스트, 이미지, 음성을 통합 처리하며, 경량화 기술을 통해 모바일 환경에서도 강력한 AI 모델을 실행할 수 있게 되었다. 또한 설명 가능한 AI에 대한 요구가 증가하면서 모델의 의사결정 과정을 해석하는 기술이 발전하고 있다.

효율성 개선을 통해 더 적은 데이터와 계산 자원으로 높은 성능을 달성하는 방향으로 연구가 진행되고 있으며, 특정 도메인에 최적화된 전문화된 모델들이 지속적으로 개발되고 있다.

'● Data Insights > AI' 카테고리의 다른 글

| Federated Learning과 Edge AI를 활용한 분산 머신러닝 아키텍처 (1) | 2025.11.20 |

|---|---|

| 국가공인 AI 자격증 AICE 종합 정보 (0) | 2025.11.18 |

| AI 데이터센터 심층 분석: 기회와 위기의 양면성 (3) | 2025.11.12 |

| LLM API 활용 가이드: 개발자가 알아야 할 필수 역량 (0) | 2025.11.12 |

| 멀티모달 AI와 에이전트의 시대: LLM 현재와 미래 (0) | 2025.11.11 |